Ein analoges Signal, z.B. eine Schallwelle die aus einem Lautsprecher kommt. Das Signal ändert sich fortlaufend (kontinuierlich). | Damit Daten in einem internet übertragen werden können, müssen sie digitalisiert werden. Zur Umwandlung in ein digitales Signal wird ein analoges Ausgangssignal in feste Zeit-Abschnitte zerlegt. Bei der Aufnahme einer Audio-CD wird das Ausgangssignal z.B. 44.100-mal pro Sekunde abgetastet, also jede Sekunde in 44.100 Schnipsel (samples) zerteilt. |

Das Analoge Signal wird in (Zeit-)Abschnitte zerlegt. | Der Wert an jeder der 'Schnittstellen' wird erfasst (die Kringel). Details die feiner sind als dieses Zeitraster werden nicht erfasst. Die einzelnen Schnipsel können jeden beliebigen Wert besitzen. |

Die Werte der einzelnen Abschnitte werden in das Werte-Raster eingepasst. | Um diese Werte in Zahlenform darstellen zu können, werden sie durch Rundung in ein festes Werte-Raster eingepasst. Der genaue Wert (Kringel) wird durch den nächstliegenden Wert des Rasters ersetzt (Kreuz). Das Digitalsignal besteht schließlich nur noch aus der so gewonnenen Zahlenreihe. |

Ob der damit unvermeidlich verbundene Qualitätsverlust relevant ist, müssen letztlich die NutzerInnen entscheiden. So ist die Bevorzugung von Vinyl-Platten gegenüber Audio-CDs bei einer Minderheit von HiFi-Freaks sicher nicht (nur) deren kollektiver Halluzination geschuldet, sondern Resultat des fundamentalen Unterschieds zwischen analoger und digitaler (d.h. kontinuierlicher und diskreter) Abbildung.

Für den Hausgebrauch wird dieser Unterschied immer weniger relevant. Digitalisierungstechik ist mittlerweile zur Massenware geworden (Hendi, Digitalkamera, DVBT, ...). Und selbst wenn jemand noch einen Analog-Telefonanschluss mit Omas Telefon als Endgerät hat, spätestens in der nächsten Vermittlungsstelle ist Schluss mit analog, weil dort digitalisiert werden muss. Denn auch das Telefonnetz ist mittlerweile im Innern komplett digitalisiert. Insofern ist die Digitalität von internet-Technologie nichts aufregend Neues, bildet aber wegen der perfekten Kopierbarkeit digitaler Daten eine wichtige konzeptionelle Grundlage des Internet und seiner Nutzung.

Solange die Zahlenreihe des Digitalsignals beim Zielsystem überhaupt lesbar ist, ist die Übertragung vollkommen verlustfrei und störsicher. Eine Störung kann bis zu einem gewissen Grad als 'Nicht-Zahlenwert' aussortiert werden oder wird erst gar nicht erfasst. Die Übertragung eines Digitalsignals stellt deshalb an das Übertragungssystem wesentlich geringere Anforderungen als eine vergleichbar gute Übertragung eines Analogsignals.

Die Unabhängigkeit vom Übertragungsmedium ist zwar als technisches Prinzip spannend, aber für den Hausgebrauch auf den ersten Blick uninteressant. Schaut man sich aber die diversen Zugangsmöglichkeiten der HausgebraucherInnen zum Internet an, so ist dies für das Wachstum der TeilnehmerInnenzahlen am Internet doch sehr relevant. Der Zugang kann über analoge (Modem) oder digitale (ISDN) Telefonanschlüsse erfolgen, über DSL wie über Kabelfernsehanschlüsse, über Funk (WLAN) oder Satellit etc. Alles geht, solange das Medium eine digitale Übertragung in beide Richtungen erlaubt. Entsprechendes gilt auch im Inneren des Internet, wo zunehmend optische Übertragungswege (Glasfaserkabel) wegen ihrer hohen Bandbreite genutzt werden.

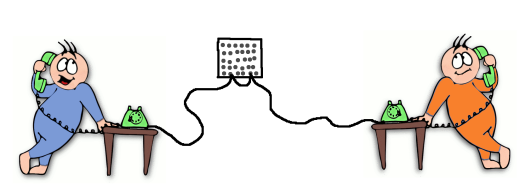

Telefon: leitungsorientierte Übertragung

Auch die Paketorientierung (packet switching) eines internet ist für die NutzerInnen erstmal unsichtbar.

Die Paketorientierung ist ein wesentlicher Unterschied zur inneren Logik der leitungsorientierten Telefonnetze. Bei den leitungsorientierten Telefonnetzen gibt es eine direkte Verbindung zwischen 2 Teilnehmern. In den Anfangszeiten der Telefonie wurden diese Verbindungen in den Vermittlungsstellen von Hand zusammen gestöpselt. Nur die beiden Teilnehmer nutzen diese Verbindung. Über die Verbindung wird das Signal transportiert. Und zwar alles schön der Reihe nach. Nach erfolgter Übertragung wird die Verbindung unterbrochen.

Internet: paketorientierte Übertragung

Im Internet wird statt dessen 'packet switching' eingesetzt. Die Übertragung erfolgt ganz anders. Zusammengehörige Daten werden in kleine Pakete aufgeteilt und unabhängig voneinander zu ihrem Ziel transportiert. Die einzelnen Datenpakete können dabei auf unterschiedlichen Routen zum Ziel gelangen. Eine Leitung kann dabei für mehrere Datenübertragungen gleichzeitig genutzt werden.

Wie bei echten Paketen wird jedes Datenpaket mit Absender- und Empfängeradresse versehen. Statt der Postanschrift werden für Datenpakete allerdings IP-Adressen verwendet. Die gebräuchlichste Form von IP-Adressen sind heute (noch) die IPv4-Adressen. Eine solche Adresse besteht aus vier Zahlen, die jeweils zwischen 0 und 255 liegen und mit einem Punkt getrennt werden, beispielsweise 127.0.0.1.

Wie bei der Post erfolgt der Transport der Pakete über mehrere Zwischenstationen. Was bei der Post die Verteilzentralen sind, übernehmen im Internet die Router. Da jedes Paket mit Ursprungs- und Zieladresse gekennzeichnet ist, muss ein Router nichts über den Datenstrom wissen, zu dem ein Paket gehört. Er muss das Paket nur einen Schritt näher zu seinem Ziel bringen.

Kommt ein Datenpaket an einem Router an, ermittelt der Router den besten Weg zum Ziel. Jeder Router hat mindestens zu zwei anderen Routern eine Verbindung. Mit diesen tauscht er Informationen aus, wer welche anderen Router erreichen kann. Auf Basis dieser Informationen schickt der Router das Datenpaket an den benachbarten Router, der dem Ziel des Pakets am nächsten ist. Zum Informationsaustausch zwischen den Routern gibt es eigene Protokolle, die Routing-Protokolle (z.B. BGP, OSPF, ...).

Die Paketorientierung ist nicht nur ein wesentlicher Unterschied zur inneren Logik der leitungsorientierten Telefonnetze. Sie ist auch konzeptionell relevant, da sie die Endknoten wichtiger macht und die Zwischenknoten des Netzes voneinander unabhängiger. Fällt ein Router aus, wird einfach eine andere Route genommen.

Technischer Sinn eines internet ist es, jederzeit beliebige Verbindungen zwischen allen angeschlossenen Geräten (hosts) zu ermöglichen. Alle NutzerInnen sollen jederzeit die Möglichkeit haben auf alle von anderen hosts zur Verfügung gestellten (Daten-)Dienste zuzugreifen. Umgekehrt kann prinzipiell jede/r TeilnehmerIn selbst solche Dienste anbieten, solange sein Computer im jeweiligen internet erreichbar ist. Unter dem Stichwort "file sharing" ist der/die LeserIn ja vielleicht schon einmal einem Kollateralschaden dieses grundlegenden internet-Konzepts begegnet.

Mit den herstellerneutralen Standards kommen wir nun auf die meta-technische Ebene des Internet-Prozesses. Die im Internet angewandte Standardisierungsmethodik [Bradner], [Crocker] ist u.a. eine wichtige Sicherung gegen Monopolisierungsversuche - eine reale Gefahr, die immer wieder gern von Bill Gates Firma veranschaulicht wird. Da in einem internet Geräte und Programme unterschiedlicher Hersteller kooperieren müssen, ist eine Beachtung der Standards für die Hersteller unverzichtbar um "mitspielen" zu können. Gute Standards tragen dazu bei, dass die von ihnen beschriebene Technik von den NutzerInnen akzeptiert und genutzt wird. Dazu sollten technisches Fachwissen, ökonomische Umsetzung und NutzerInneninteressen möglichst an einem Strang ziehen.

Dies ist im Internet offenbar besser gelöst als in den traditionellen Gremien, die auf national strukturierten Normungsgremien basieren. Anders wäre das rasante Wachstum des Internet technisch gar nicht umsetzbar gewesen. Zum Vergleich sei hier beispielhaft an die Monopolbemühung "BTX" der seeligen Bundespost erinnert. Gegen das offene Internet konnte sich BTX nicht durchsetzen und wurde 2007 endgültig eingestellt. Auch die internationale Normungsorganisation ISO konnte sich mit ihren OSI-Protokollen nicht durchsetzen (s. dazu [Rutkowski], [Crocker]). Brauchbare OSI-Bemühungen werden aber durchaus als internet-Techniken assimiliert z.B. X.500.

Die Internationale Fernmeldeunion ITU (eine Unterorganisation der UN) bedient sich neuerdings für Hochleistungsprotokolle bei der IETF (dem Standardisierungsgremium des Internet) bzw. muss sich mit ihr arrangieren (s. [ITU], [IAB]). Internet-nahe Protokolle wie Ethernet (ein für LANs verwendeter Standard) und MPLS breiten sich nämlich auch in Transportnetzen aus, die sowohl vom Telefonnetz als auch dem Internet genutzt werden.

Wachstum braucht quantitative Offenheit, und die ist im Internet durch die offene Netzwerkarchitektur (Unabhängigkeit vom Übertragungsmedium bis beliebige Verbindungen) gegeben. Außerdem fehlen Verknappungsinstanzen, wie staatliche Lizenzvergabe oder ganz allgemein Monopole. Für die Einbindung eines neuen internet in "das" Internet sind lediglich drei Schritte erforderlich:

- Herstellen einer geeigneten physikalischen Übertragungsverbindung.

- Eine koordinierte Vergabe eindeutiger IP-Adressen an den neuen Teil des Internet.

- Bekanntmachung der neuen Verbindung in den globalen Routingtabellen.

Der Clou: das neue internet, das dadurch Teil des großen Internet geworden ist, kann nun seinerseits weitere, bisher abgekoppelte internets in "das" Internet assimilieren (sofern ausreichend Übertragungskapazitäten vorhanden sind).

Das u.a. dadurch ermöglichte rasante Internet-Wachstum (insbesondere seit Mitte der 90er Jahre) hat allerdings eine absolute Schranke. Die Zahl der verschiedenen IPv4-Adressen ist wegen deren fester Länge von 32 bit endlich. Es kann nur ca. 4 Milliarden verschiedener IPv4-Adressen geben. Hier ist ein Ende der technischen Fahnenstange absehbar. Aber es gibt ("natürlich") auch technische Konzepte dagegen, wie etwa das mangelverwaltende NAT (mehrere Rechner teilen sich eine Adresse und sind dadurch keine vollwertigen hosts mehr) oder vor allem das neue internet protocol IPv6 mit 128 bit Adressen ("genug für alle und alles":).

Ohne pauschal einem "Umschlagen der Quantität in Qualität" nach- oder gegenzureden: das bisherige quantitative Wachstum des Internet ist nicht ohne qualitatives Wachstum denkbar. Beispielsweise wurde kurz nach dem Umstellen des damaligen ARPANET, von NCP (Network Control Program) auf das noch heute gebrauchte IPv4, 1983 das domain name system (DNS) entwickelt.

Seitdem können im Internet statt der IP-Adressen auch Domainnamen (wie z.B. example.org) verwendet werden. Das war nötig, um das gewachsene Netz trotz der vielen hosts für Menschen nutzbar zu halten. Menschen können sich nun mal (Domain-)Namen besser merken als die langen Ziffernkolonnen von IP-Adressen (die sich darüber hinaus bei Netzwerkänderungen auch noch ändern können). Das DNS übersetzt die Domainnamen in die für die hosts verständlichen IP-Adressen. Das DNS ist eine dezentral verwaltete und betriebene globale Datenbank - ein globales "Telefonbuch" in dem nachgeschaut wird, welche IP-Adresse zu welchem Domainnamen gehört (und umgekehrt).

Seit den 1990ern wird BGP als Routingprotokoll zwischen den einzelnen, autonom verwalteten Netzen (autonomous systems - AS) genutzt. Damit bleibt die Illusion real, dass jede jeden im Internet erreichen kann. Und das trotz des enormen quantitativen Wachstums. Zur Zeit (Ende 2008) enthalten die mit BGP dezentral verwalteten globalen Routing Tabellen etwa 30.000 autonome Systeme mit insgesamt 270.000 sogenannten IPv4-Präfixen (ca. "Netze").

Die Integration immer neuer Techniken, wie z.B. e-mail, Ethernet, Unix, das World Wide Web oder Internettelefonie, war einerseits eine Reaktion auf quantitatives Wachstum (Anzahl der hosts und der TeilnehmerInnen, verfügbare Bandbreite und Rechenleistung), andererseits auch die Voraussetzung für qualitatives Wachstum. Rückgrat des qualitativen Wachstumsprozesses wiederum ist der offene Standardisierungsprozess. Nicht nur technologische Qualitätssprünge wechselwirken mit quantitativen, auch organisatorische, wie in der ersten Hälfte der 1990er der Übergang vom überwiegend staatlich finanzierten Forschungsnetz zum marktförmig kommerziellen, das heißt in unserer Epoche: kapitalistischen Internet.