- Entwicklung und Situation des Internet sowie seine wechselseitigen Bezüge zum Anarchismus -

Versionsinformation: DocBooksource $Revision: 1.30 $

Textvariante: Ausführliche Version für Internet-EinsteigerInnen. ("maxi")

Zusammenfassung

Der erste Teil dieses Textes beschreibt das Internet - seine technischen Grundideen, seine geschichtliche Entwicklung, seine Organisation und einige seiner Probleme.

Im zweiten Teil wird das Internet in wechselseitiger Beziehung zum Anarchismus betrachtet. Es werden Eigenschaften des Internet wie Dezentralität, Einheit und Wachstumsdynamik zur Inspiration für den Anarchismus interpretiert. Umgekehrt wird der Anarchismus zur Analyse praktischer und ideologischer Probleme des Internet herangezogen. Schließlich werden konkrete Handlungsbereiche für die libertäre Internetnutzung aufgezeigt.

Der erste Teil des Textes kann auch für sich alleine gelesen werden. Der zweite Teil baut auf den Erklärungen des ersten Teils auf.

Der Text ist in drei Varianten ("mini", "midi" und "maxi") verfügbar. Die vor allem im ersten Teil kürzere "mini" Variante entspricht dem Text des Beitrages "Anarchismus und Internet" in der Anthologie Anarchismus 2.0(ISBN 3-89657-052-8), die von Hans Jürgen Degen und Jochen Knoblauch herausgegeben wurde und im April 2009 im Schmetterling Verlag erschien. In der "maxi" Variante des Textes werden Begriffe und Zusammenhänge des Internet ausgiebig dargestellt, damit sie auch für Laien verständlich sind.

Die jeweils aktuelle Version dieses Textes wird über das Internet auf folgender Website verfügbar gemacht: http://projekte.free.de/anarchismus-und-internet/

Inhaltsverzeichnis

- Einleitung

- 1. Das Internet

- 2. Internet undstattoder Anarchismus

- Quellen

- Index

Abbildungsverzeichnis

Aus einer anarchistischen Perspektive betrachten wir mit diesem Text [ FNord ] das Internet, seine Technologie und seine historischen und gesellschaftlichen Dimensionen. Voraussetzung dafür ist zumindest eine ungefähre Vorstellung davon, wie das Internet funktioniert. Deshalb kommen wir um einige technische Erklärungen nicht herum.

Da im Verlaufe dieses Beitrags auch viele technische Begriffe auftauchen werden, zur Klarstellung eines vorweg: Eine rein technische Lösung zur Befreiung der Gesellschaft (von Herrschaft, Ausbeutung, Staat, ...) kann es nicht geben. "Befreiung" ist ein an Menschen gebundener Begriff. Nur sie können die urhebende und beurteilende Instanz einer Befreiung sein. Es ist aber auch klar, dass Menschen, die sich befreien (wollen), dazu organisatorische und auch technische Hilfsmittel benutzen. Von der klandestinen Kommunikation über die aufklärerische Betätigung der Druckerpresse bis hin zu bewaffneten Milizen findet sich ein breites Spektrum historisch jeweils verfügbarer organisatorischer und technischer Mittel auch bei anti-autoritären, anarchistischen Befreiungsbestrebungen. Dies gilt offensichtlich auch heute für die Nutzung des Internet, vor allem zum Zwecke der internen und externen Kommunikation.

Es wäre sicher ein interessantes und nützliches Projekt, libertäre Internetnutzung - etwa analog zu [ DadA ] (Datenbank des deutschsprachigen Anarchismus) bei Druckmedien - zu katalogisieren und zu analysieren. Es soll aber im Folgenden um andere, tiefer liegende Bezüge zwischen Anarchismus und Internet gehen. Diese Bezugnahmen basieren auf bzw. resultieren in einer Doppelthese: dass nämlich einerseits "das Internet" Prinzipien und Erfahrungen "des Anarchismus" bewusst(er) in seine Entwicklung aufnehmen könnte (bzw. sollte), während andererseits "der Anarchismus" die Prinzipien und Erfahrungen "des Internet" zum Aufbau gesellschaftlicher Freiräume und emanzipatorischer Entwicklungsprozesse wirksam machen könnte - und u.E. auch sollte.

Die angegebenen Quellen sind soweit möglich über das Internet abrufbare Originalarbeiten und daher überwiegend englischsprachig. Wer Muße für eine ausführlichere deutschsprachige Darstellung hat, dem sei das Internet Kapitel ([ Grassmuck ], S. 179ff) des Buches "Freie Software" empfohlen, welches sowohl zum download als auch staatlich subventioniert als Papierausgabe von der Bundeszentrale für politische Bildung bereitgestellt wird. Ebenfalls brauchbar und im Internet abrufbar sind [ Musch ] und [ Gillies ].

Inhaltsverzeichnis

Zunächst ein kurzer Überblick über die Funktionsweise des Internet. Danach schauen wir uns die wesentlichen Eigenschaften etwas näher an.

Das Internet ist die offene Form der geschlossenen Anstalt.

Spaß beiseite: Das Internet ist das weltweit größte Datenübertragungsnetz, das auf internet-Technologie basiert.

Computer bauen Verbindungen untereinander auf, um Daten auszutauschen. Sie bilden ein sogenanntes Datenübertragungsnetz. Dazu wird die seit den 1960iger Jahren entwickelte internet-Technologie genutzt. Ein solches Datenübertragungsnetz auf Basis der internet-Technologie funktioniert auch ohne Anbindung an das "Internet". Zur Unterscheidung zu dem "Internet" werden in diesem Text zwei Schreibweisen verwendet:

- Internet mit großem I meint "das" Internet,

- internet mit kleinem i meint ein beliebiges Datenübertragungsnetz, das internet-Technologie verwendet, unabhängig davon, ob eine Verbindung zu "dem" Internet besteht oder nicht.

Neben den unterschiedlichsten Computern und deren diversen Betriebssystemen gibt es im Internet auch noch andere Geräte (z.B. Router, Drucker, Telefone). Damit sich die einzelnen Geräte (hosts) untereinander "verstehen" und Daten austauschen können, gibt es gemeinsame Standards, so genannte Protokolle.

Kommunizieren zwei Computer über diese (Netzwerk-)Protokolle, tauschen sie dabei unterschiedliche Arten von Informationen aus. Zum Beispiel kann ein Computer über das Protokoll zunächst Informationen über sich selbst schicken und sich damit beim anderen Computer identifizieren. Der angewählte Computer kann dann entscheiden, ob er überhaupt Daten austauschen möchte.

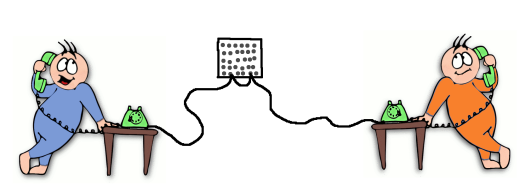

Beim Datenaustausch gibt es immer einen, der Informationen sendet und einen, der sie empfängt. Der anbietende Computer wird Server genannt (engl. "to serve"= dienen, versorgen), der empfangende heißt Client (engl. Kunde). Der Client schickt Anfragen des Benutzers mit Hilfe eines speziellen Protokolls an den Server.

|

|

Damit Daten zwischen Computern ausgetauscht werden können, müssen sie miteinander verbunden sein. Zuhause oder in Betrieben kann eine Verbindung über lokale Netzwerke (engl. Local Area Network, kurz LAN) erfolgen. Sind die Geräte nicht durch ein Kabel verbunden, sondern per Funk, wird das Netz WLAN genannt. Das W steht für Wireless (engl. ohne Kabel). |

|

|

Rechnernetze, die sich über große Entfernungen hinweg erstrecken, heißen Wide Area Network (WAN). Einige WANs gehören bestimmten Organisationen oder Unternehmen und können nur von diesen genutzt werden. Andere WANs werden durch Provider betrieben, um einen Zugang zum Internet anzubieten. Über Modem, DSL-Leitung, Fernsehkabel etc. können sich die Computer der Kunden mit den Internet-Servern der Provider verbinden. |

Das englischsprachige Wort "internet" kann als Zusammenziehung von "interconnected networks" gelesen werden, meint also miteinander verbundene Netzwerke, ein Netz von Netzen. Das Internet ist also ein Computernetz-Netz.

Das Internet ist kein einheitliches Netzwerk, sondern ein Verbund aus vielen kleinen, geographisch oder organisatorisch begrenzten Netzen und damit ein dezentrales Netzwerk.

Einen einzelnen "Superrechner", der das Internet steuert gibt es nicht. Es sind tausende von Rechnern die miteinander verknüpft sind. Sie bilden gewissermaßen das Rückgrat des Internet. Die breitbandigen Hauptstrecken welche die Internet-Server miteinander verbinden heißen auch so: Backbone. Über diese Leitungen läuft der größte Teil des Datenverkehrs.

Weil es ein einheitliches Internet nicht gibt, sind Regeln erforderlich, die den Datenaustausch zwischen den vielen weltweiten Netzen festlegen. Dadurch entstehen Hierarchien, aber dazu später mehr.

Besteht eine Verbindung zum Internet können die unterschiedlichen Dienste genutzt werden. Einer der wichtigsten Dienste ist das World Wide Web (WWW). Auch wenn sehr viele AnwenderInnen meinen das WWW und das Internet wären das Gleiche, ist dem nicht so. Internet ist der Oberbegriff für die vernetzten Computernetze einschließlich der angebotenen Dienste. Weitere Dienste im Internet sind z.B. E-Mail, DNS, FTP, Telnet und Usenet.

Das WWW ist ein System zur Darstellung von Webseiten (bzw. Dokumenten).

Wer sich eine Webseite ansehen möchte benötigt dazu ein spezielles Programm: einen Browser (z.B. Mozilla Firefox).

Die einzelnen Dokumente sind auf einem Web-Server gespeichert. Jedes Dokument hat eine eindeutige Adresse, die URL (uniform resource locator). Diese gibt man in die Adresszeile des Browsers ein. Der Browser fordert dann vom Server das Dokument an und sorgt für die Darstellung der Seite auf dem Bildschirm.

Die Dokumente haben im WWW ein spezielles Format: HTML (Hyper Text Markup Language). Mit HTML können Querverweise (Links) zu anderen Dokumenten hergestellt werden. Auch Bilder, Filme oder Audiodaten können damit in ein Dokument eingebunden werden. Für die Übertragung von Webseiten wird das Protokoll HTTP (Hypertext Transfer Protocol) verwendet.

E-Mail steht für "electronic mail" ("elektronische Post"). E-Mails bestehen nur aus Textzeichen. Es können aber auch Bilder oder andere Dateien übertragen werden. Diese müssen dazu passend kodiert werden. Aktuelle E-Mailprogramme erledigen das automatisch. Für die Übertragung von E-Mails gibt es spezielle Protokolle. Die wichtigsten sind SMTP, POP3 und IMAP.

Um E-Mails versenden und empfangen zu können benötigt man ein Mail-Postfach, das heißt eine E-Mail-Adresse (z.B. susi@beispiel.org). Diese erhält man z.B. von seinem Internet-Provider. Möchte man jemandem schreiben, muss man die E-Mail-Adresse des Empfängers kennen. An dessen Postfach wird die E-Mail gesendet. Der Empfänger kann die E-Mail dann vom Mail-Server seines Providers abrufen.

Zum Schreiben, Versenden, Abrufen und Lesen von E-Mails kann ein E-Mail-Programm (ein Mail-Client) genutzt werden; z.B. KMail oder Mozilla Thunderbird. Mail-Provider bieten aber auch Web-Schnittstellen an. Über die Webseite seines Providers kann man damit ebenfalls auf seine E-Mails zugreifen oder E-Mails schreiben und versenden.

E-Mails können auf jedem Rechner gelesen werden, den die E-Mail auf ihrem Weg vom Absender zum Empfänger passiert (und das können etliche sein). Vergleicht man das mit der herkömmlichen Briefpost ist eine E-Mail wie eine Postkarte. Der Postbote und alle Personen in den Verteilzentralen können die Postkarte lesen. Mit E-Mails ist das genauso. Um das zu verhindern kann man E-Mails verschlüsseln. Dazu später mehr.

DNS - Das Domain Name System ist einer der wichtigsten Dienste im Internet, auch wenn Mensch nicht viel davon merkt. Das DNS sorgt dafür, dass Anfragen oder E-Mails bei dem richtigen Rechner ankommen. Auch dazu später mehr.

FTP ("file transfer protocol" – Datenübertragungsprotokoll) bietet die Möglichkeit, auch große Dateien zu übermitteln.

Mit Hilfe von Telnet loggt man sich auf einem entfernten Rechner ein, um auf diesem zu arbeiten.

Und der Dienst Usenet meint die Gesamtheit aller Newsgroups, also die schwarzen Bretter im Internet.

|

Ein analoges Signal, z.B. eine Schallwelle die aus einem Lautsprecher kommt. Das Signal ändert sich fortlaufend (kontinuierlich). |

Damit Daten in einem internet übertragen werden können, müssen sie digitalisiert werden. Zur Umwandlung in ein digitales Signal wird ein analoges Ausgangssignal in feste Zeit-Abschnitte zerlegt. Bei der Aufnahme einer Audio-CD wird das Ausgangssignal z.B. 44.100-mal pro Sekunde abgetastet, also jede Sekunde in 44.100 Schnipsel (samples) zerteilt. |

|

Das Analoge Signal wird in (Zeit-)Abschnitte zerlegt. |

Der Wert an jeder der 'Schnittstellen' wird erfasst (die Kringel). Details die feiner sind als dieses Zeitraster werden nicht erfasst. Die einzelnen Schnipsel können jeden beliebigen Wert besitzen. |

|

Die Werte der einzelnen Abschnitte werden in das Werte-Raster eingepasst. |

Um diese Werte in Zahlenform darstellen zu können, werden sie durch Rundung in ein festes Werte-Raster eingepasst. Der genaue Wert (Kringel) wird durch den nächstliegenden Wert des Rasters ersetzt (Kreuz). Das Digitalsignal besteht schließlich nur noch aus der so gewonnenen Zahlenreihe. |

Ob der damit unvermeidlich verbundene Qualitätsverlust relevant ist, müssen letztlich die NutzerInnen entscheiden. So ist die Bevorzugung von Vinyl-Platten gegenüber Audio-CDs bei einer Minderheit von HiFi-Freaks sicher nicht (nur) deren kollektiver Halluzination geschuldet, sondern Resultat des fundamentalen Unterschieds zwischen analoger und digitaler (d.h. kontinuierlicher und diskreter) Abbildung.

Für den Hausgebrauch wird dieser Unterschied immer weniger relevant. Digitalisierungstechik ist mittlerweile zur Massenware geworden (Hendi, Digitalkamera, DVBT, ...). Und selbst wenn jemand noch einen Analog-Telefonanschluss mit Omas Telefon als Endgerät hat, spätestens in der nächsten Vermittlungsstelle ist Schluss mit analog, weil dort digitalisiert werden muss. Denn auch das Telefonnetz ist mittlerweile im Innern komplett digitalisiert. Insofern ist die Digitalität von internet-Technologie nichts aufregend Neues, bildet aber wegen der perfekten Kopierbarkeit digitaler Daten eine wichtige konzeptionelle Grundlage des Internet und seiner Nutzung.

Solange die Zahlenreihe des Digitalsignals beim Zielsystem überhaupt lesbar ist, ist die Übertragung vollkommen verlustfrei und störsicher. Eine Störung kann bis zu einem gewissen Grad als 'Nicht-Zahlenwert' aussortiert werden oder wird erst gar nicht erfasst. Die Übertragung eines Digitalsignals stellt deshalb an das Übertragungssystem wesentlich geringere Anforderungen als eine vergleichbar gute Übertragung eines Analogsignals.

Die Unabhängigkeit vom Übertragungsmedium ist zwar als technisches Prinzip spannend, aber für den Hausgebrauch auf den ersten Blick uninteressant. Schaut man sich aber die diversen Zugangsmöglichkeiten der HausgebraucherInnen zum Internet an, so ist dies für das Wachstum der TeilnehmerInnenzahlen am Internet doch sehr relevant. Der Zugang kann über analoge (Modem) oder digitale (ISDN) Telefonanschlüsse erfolgen, über DSL wie über Kabelfernsehanschlüsse, über Funk (WLAN) oder Satellit etc. Alles geht, solange das Medium eine digitale Übertragung in beide Richtungen erlaubt. Entsprechendes gilt auch im Inneren des Internet, wo zunehmend optische Übertragungswege (Glasfaserkabel) wegen ihrer hohen Bandbreite genutzt werden.

Telefon: leitungsorientierte Übertragung

Auch die Paketorientierung (packet switching) eines internet ist für die NutzerInnen erstmal unsichtbar.

Die Paketorientierung ist ein wesentlicher Unterschied zur inneren Logik der leitungsorientierten Telefonnetze. Bei den leitungsorientierten Telefonnetzen gibt es eine direkte Verbindung zwischen 2 Teilnehmern. In den Anfangszeiten der Telefonie wurden diese Verbindungen in den Vermittlungsstellen von Hand zusammen gestöpselt. Nur die beiden Teilnehmer nutzen diese Verbindung. Über die Verbindung wird das Signal transportiert. Und zwar alles schön der Reihe nach. Nach erfolgter Übertragung wird die Verbindung unterbrochen.

Internet: paketorientierte Übertragung

Im Internet wird statt dessen 'packet switching' eingesetzt. Die Übertragung erfolgt ganz anders. Zusammengehörige Daten werden in kleine Pakete aufgeteilt und unabhängig voneinander zu ihrem Ziel transportiert. Die einzelnen Datenpakete können dabei auf unterschiedlichen Routen zum Ziel gelangen. Eine Leitung kann dabei für mehrere Datenübertragungen gleichzeitig genutzt werden.

Wie bei echten Paketen wird jedes Datenpaket mit Absender- und Empfängeradresse versehen. Statt der Postanschrift werden für Datenpakete allerdings IP-Adressen verwendet. Die gebräuchlichste Form von IP-Adressen sind heute (noch) die IPv4-Adressen. Eine solche Adresse besteht aus vier Zahlen, die jeweils zwischen 0 und 255 liegen und mit einem Punkt getrennt werden, beispielsweise 127.0.0.1.

Wie bei der Post erfolgt der Transport der Pakete über mehrere Zwischenstationen. Was bei der Post die Verteilzentralen sind, übernehmen im Internet die Router. Da jedes Paket mit Ursprungs- und Zieladresse gekennzeichnet ist, muss ein Router nichts über den Datenstrom wissen, zu dem ein Paket gehört. Er muss das Paket nur einen Schritt näher zu seinem Ziel bringen.

Kommt ein Datenpaket an einem Router an, ermittelt der Router den besten Weg zum Ziel. Jeder Router hat mindestens zu zwei anderen Routern eine Verbindung. Mit diesen tauscht er Informationen aus, wer welche anderen Router erreichen kann. Auf Basis dieser Informationen schickt der Router das Datenpaket an den benachbarten Router, der dem Ziel des Pakets am nächsten ist. Zum Informationsaustausch zwischen den Routern gibt es eigene Protokolle, die Routing-Protokolle (z.B. BGP, OSPF, ...).

Die Paketorientierung ist nicht nur ein wesentlicher Unterschied zur inneren Logik der leitungsorientierten Telefonnetze. Sie ist auch konzeptionell relevant, da sie die Endknoten wichtiger macht und die Zwischenknoten des Netzes voneinander unabhängiger. Fällt ein Router aus, wird einfach eine andere Route genommen.

Technischer Sinn eines internet ist es, jederzeit beliebige Verbindungen zwischen allen angeschlossenen Geräten (hosts) zu ermöglichen. Alle NutzerInnen sollen jederzeit die Möglichkeit haben auf alle von anderen hosts zur Verfügung gestellten (Daten-)Dienste zuzugreifen. Umgekehrt kann prinzipiell jede/r TeilnehmerIn selbst solche Dienste anbieten, solange sein Computer im jeweiligen internet erreichbar ist. Unter dem Stichwort "file sharing" ist der/die LeserIn ja vielleicht schon einmal einem Kollateralschaden dieses grundlegenden internet-Konzepts begegnet.

Mit den herstellerneutralen Standards kommen wir nun auf die meta-technische Ebene des Internet-Prozesses. Die im Internet angewandte Standardisierungsmethodik [ Bradner ], [ Crocker ] ist u.a. eine wichtige Sicherung gegen Monopolisierungsversuche - eine reale Gefahr, die immer wieder gern von Bill Gates Firma veranschaulicht wird. Da in einem internet Geräte und Programme unterschiedlicher Hersteller kooperieren müssen, ist eine Beachtung der Standards für die Hersteller unverzichtbar um "mitspielen" zu können. Gute Standards tragen dazu bei, dass die von ihnen beschriebene Technik von den NutzerInnen akzeptiert und genutzt wird. Dazu sollten technisches Fachwissen, ökonomische Umsetzung und NutzerInneninteressen möglichst an einem Strang ziehen.

Dies ist im Internet offenbar besser gelöst als in den traditionellen Gremien, die auf national strukturierten Normungsgremien basieren. Anders wäre das rasante Wachstum des Internet technisch gar nicht umsetzbar gewesen. Zum Vergleich sei hier beispielhaft an die Monopolbemühung "BTX" der seeligen Bundespost erinnert. Gegen das offene Internet konnte sich BTX nicht durchsetzen und wurde 2007 endgültig eingestellt. Auch die internationale Normungsorganisation ISO konnte sich mit ihren OSI-Protokollen nicht durchsetzen (s. dazu [ Rutkowski ], [ Crocker ]). Brauchbare OSI-Bemühungen werden aber durchaus als internet-Techniken assimiliert z.B. X.500.

Die Internationale Fernmeldeunion ITU (eine Unterorganisation der UN) bedient sich neuerdings für Hochleistungsprotokolle bei der IETF (dem Standardisierungsgremium des Internet) bzw. muss sich mit ihr arrangieren (s. [ ITU ], [ IAB ]). Internet-nahe Protokolle wie Ethernet (ein für LANs verwendeter Standard) und MPLS breiten sich nämlich auch in Transportnetzen aus, die sowohl vom Telefonnetz als auch dem Internet genutzt werden.

Wachstum braucht quantitative Offenheit, und die ist im Internet durch die offene Netzwerkarchitektur (Unabhängigkeit vom Übertragungsmedium bis beliebige Verbindungen) gegeben. Außerdem fehlen Verknappungsinstanzen, wie staatliche Lizenzvergabe oder ganz allgemein Monopole. Für die Einbindung eines neuen internet in "das" Internet sind lediglich drei Schritte erforderlich:

- Herstellen einer geeigneten physikalischen Übertragungsverbindung.

- Eine koordinierte Vergabe eindeutiger IP-Adressen an den neuen Teil des Internet.

- Bekanntmachung der neuen Verbindung in den globalen Routingtabellen.

Der Clou: das neue internet, das dadurch Teil des großen Internet geworden ist, kann nun seinerseits weitere, bisher abgekoppelte internets in "das" Internet assimilieren (sofern ausreichend Übertragungskapazitäten vorhanden sind).

Das u.a. dadurch ermöglichte rasante Internet-Wachstum (insbesondere seit Mitte der 90er Jahre) hat allerdings eine absolute Schranke. Die Zahl der verschiedenen IPv4-Adressen ist wegen deren fester Länge von 32 bit endlich. Es kann nur ca. 4 Milliarden verschiedener IPv4-Adressen geben. Hier ist ein Ende der technischen Fahnenstange absehbar. Aber es gibt ("natürlich") auch technische Konzepte dagegen, wie etwa das mangelverwaltende NAT (mehrere Rechner teilen sich eine Adresse und sind dadurch keine vollwertigen hosts mehr) oder vor allem das neue internet protocol IPv6 mit 128 bit Adressen ("genug für alle und alles":).

Ohne pauschal einem "Umschlagen der Quantität in Qualität" nach- oder gegenzureden: das bisherige quantitative Wachstum des Internet ist nicht ohne qualitatives Wachstum denkbar. Beispielsweise wurde kurz nach dem Umstellen des damaligen ARPANET, von NCP (Network Control Program) auf das noch heute gebrauchte IPv4, 1983 das domain name system (DNS) entwickelt.

Seitdem können im Internet statt der IP-Adressen auch Domainnamen (wie z.B. example.org) verwendet werden. Das war nötig, um das gewachsene Netz trotz der vielen hosts für Menschen nutzbar zu halten. Menschen können sich nun mal (Domain-)Namen besser merken als die langen Ziffernkolonnen von IP-Adressen (die sich darüber hinaus bei Netzwerkänderungen auch noch ändern können). Das DNS übersetzt die Domainnamen in die für die hosts verständlichen IP-Adressen. Das DNS ist eine dezentral verwaltete und betriebene globale Datenbank - ein globales "Telefonbuch" in dem nachgeschaut wird, welche IP-Adresse zu welchem Domainnamen gehört (und umgekehrt).

Seit den 1990ern wird BGP als Routingprotokoll zwischen den einzelnen, autonom verwalteten Netzen (autonomous systems - AS) genutzt. Damit bleibt die Illusion real, dass jede jeden im Internet erreichen kann. Und das trotz des enormen quantitativen Wachstums. Zur Zeit (Ende 2008) enthalten die mit BGP dezentral verwalteten globalen Routing Tabellen etwa 30.000 autonome Systeme mit insgesamt 270.000 sogenannten IPv4-Präfixen (ca. "Netze").

Die Integration immer neuer Techniken, wie z.B. e-mail, Ethernet, Unix, das World Wide Web oder Internettelefonie, war einerseits eine Reaktion auf quantitatives Wachstum (Anzahl der hosts und der TeilnehmerInnen, verfügbare Bandbreite und Rechenleistung), andererseits auch die Voraussetzung für qualitatives Wachstum. Rückgrat des qualitativen Wachstumsprozesses wiederum ist der offene Standardisierungsprozess. Nicht nur technologische Qualitätssprünge wechselwirken mit quantitativen, auch organisatorische, wie in der ersten Hälfte der 1990er der Übergang vom überwiegend staatlich finanzierten Forschungsnetz zum marktförmig kommerziellen, das heißt in unserer Epoche: kapitalistischen Internet.

The definition of enemy is still open.

(Die Definition von Feind ist noch offen.)

Nach dem "Sputnik-Schock" 1957 wurde im US-Kriegsministerium die (D)ARPA ((Defense) Advanced Research Projects Agency) gegründet. Ziel war der militärtechnologische Fortschritt zwecks Überlegenheit gegenüber der UdSSR. Die Forschungsbehörde DARPA arbeitete mit vielen amerikanischen Forschungseinrichtungen zusammen und förderte deren Arbeiten. Neben unmittelbar militärischen Projekten wurde auch Grundlagenforschung gefördert, etwa im Bereich der Computertechnologie. Einer der frühen Visionäre der Computernutzung im allgemeinen und von Computernetzwerken im speziellen war der Wissenschaftler am MIT (Massachusetts Institute of Technology) J.C.R. Licklider, dieser schrieb bereits 1960(!):

"It seems reasonable to envision, for a time 10 or 15 years hence, a 'thinking center' that will incorporate the functions of present-day libraries together with anticipated advances in information storage and retrieval and the symbiotic functions suggested earlier in this paper. The picture readily enlarges itself into a network of such centers, connected to one another by wide-band communication lines and to individual users by leased-wire services. In such a system, the speed of the computers would be balanced, and the cost of the gigantic memories and the sophisticated programs would be divided by the number of users." ([ Licklider I ], S. 8)

"Mit den zu erwartenden Fortschritten bei der Informationspeicherung und -aufbereitung und den zuvor in diesem Text vorgeschlagenen symbiotischen Funktionen scheint es vorstellbar zu sein, dass innerhalb der nächsten 10 oder 15 Jahre ein 'Denkzentrum' die Funktionen heutiger Büchereien übernimmt. Das Bild vervollständigt sich zu einem Netzwerk solcher Zentren, untereinander verbunden durch Breitband-Kommunikationsleitungen und verbunden mit einzelnen Benutzern die Leitungsdienste mieten. In solch einem System würde die Geschwindigkeit der Computer ausbalanciert und die Kosten der gigantischen Speicher und der ausgeklügelten Programme würde durch die Anzahl der Benutzer geteilt."

Licklider war von 1962-1964 beim ARPA als Direktor des Information Processing Techniques Office für die Forschungsförderung zuständig und schrieb dort zum Verhältnis von Militär und Forschung:

"I am hoping that there will be, in our individual efforts, enough evident advantage in cooperative programming and operation to lead us to solve th[e] problems and, thus, to bring into being the technology that the military needs. When problems arise clearly in the military context and seem not to appear in the research context, then ARPA can take steps to handle them on an ad hoc basis. As I say, however, hopefully, many of the problems will be essentially as important, in the research context as in the military context." [ Licklider II ]

Ich hoffe dass es bei unseren individuellen Anstrengungen genug evidente Vorteile durch kooperatives programmieren und arbeiten geben wird, so dass wir die Probleme lösen können und somit die Technologie bereit stellen die das Militär braucht. Wenn Probleme im militärischen Kontext auftauchen, aber scheinbar nicht im wissenschaftlichen Kontext, dann kann ARPA kurzfristig Schritte unternehmen um diese Probleme zu lösen. Aber wie ich schon sagte, werden hoffentlich viele der Probleme im wissenschaftlichen Kontext ebenso essentiell wichtig sein wie im militärischen Kontext.

Zu dieser Zeit wurde im "militärischen Kontext" bereits sehr detailliert über ausfallsichere Kommunikationsnetze nachgedacht, die gegnerische Angriffe auf die "command and control" Infrastruktur bestmöglich überstehen sollten. Am RAND, dem ersten US think tank, der unmittelbar nach dem 2. Weltkrieg zur fortgesetzten Zusammenarbeit zwischen Militär, Industrie und Wissenschaft gegründet wurde [ RAND ], wurde 1964 eine Reihe von Schriften herausgegeben. Darin beschrieb Paul Baran die Grundzüge des "Distributed Adaptive Message Block Network", eines digitalen, paketorientierten, dezentralen Kommunikationsnetzes [ Baran I ], [ Baran II ]. In Barans Konzept wurden Daten nicht mehr auf einem zentralen Rechner gesammelt, sondern in ein Computernetzwerk eingespeist. Die Daten gelangten über die unterschiedlichsten Verknüpfungen vom Startrechner zum Zielrechner. Dadurch war ein Totalausfall des Netzes kaum mehr zu befürchten.

Abbildung 1.2. Zentrale, dezentrale, verteilte Kommunikationsnetze

Zentrale, dezentrale, verteilte Kommunikationsnetze - Aus Barans Beschreibung eines digitalen, paketorientierten, vermaschten Kommunikationsnetzes

Mitte der 1960er, aber offenbar unabhängig von Baran hatte der britische Physiker und Mathematiker Donald Davies am dortigen National Physical Laboratory (NPL) ähnliche Konzepte erarbeitet [ Davies ], [ Barber ]. Und schließlich hatte der MIT-Wissenschaftler Leonard Kleinrock in der ersten Hälfte der 1960er Jahre zur Theorie der Leistungsfähigkeit digitaler Netze gearbeitet. Diese drei Wurzeln fanden vmtl. erst auf einer Konferenz 1967 zusammen, als der beim ARPA für das ARPANET verantwortliche MIT-Wissenschaftler von einem britischen Kollegen über Barans Arbeit bei RAND erfuhr [ Roberts II ], [ Leiner ]. Bis dahin waren Erfahrung und Konzept der Roberts-Gruppe gerade einmal auf der Ebene einer Kopplung von zwei Computern [ Roberts I ] angekommen. Erst mit Barans "packet switching" als Netzwerkprinzip [ Baran I ], [ Davies ] war die Basis des ARPANET komplett, auch wenn Roberts (mittlerweile?) das Gegenteil behauptet ([ Roberts II ] vs. [ Barber ], [ Baran III ]).

IMP - Interface Messaging Processor - Vorläufer der heutigen Router - Quelle: http://www.webstart.com/jed/service/

Die britische Gruppe entwickelte - mangels weitergehender Förderung immerhin - ein lokales paketorientiertes Netz (LAN = local area network) mit der relativ hohen Bandbreite von 1 Mb/s, das bis in die 1980er Jahre am NPL in Benutzung war.

Jeder Großrechner verwendete damals eine eigene, zu einem anderen System gänzlich inkompatible, Sprache. Standards zum Datenaustausch zwischen Großrechnern gab es noch nicht. Es mussten nicht nur Netzwerkprotokolle entwickelt werden, sondern auch Definitionen für einheitliche Schnittstellen. Damit beauftragte die ARPA Ende 1968 die Technologiefirma BBN (Bolt, Beranek, Newman).

Die Großrechner direkt untereinander zu verbinden wäre wahrscheinlich so ohne weiteres nicht machbar gewesen. BBN löste das Problem indem jeder Großrechner lokal an einen eigenständigen Rechner angeschlossen wurde, dem so genannten IMP ("Interface Message Processor"). Die IMPs wiederum wurden dann miteinander vernetzt und bildeten das eigentliche Netzwerk. Die IMPs können als Vorläufer der heutigen Router betrachtet werden.

Der erste IMP wurde im September 1969 an Kleinrocks Gruppe an der UCLA (University of California at Los Angeles) geliefert. Ende 1969 bildeten IMPs mit den zugehörigen hosts an vier Standorten den operativen Anfang des ARPANET. Verbunden waren sie über 50 kb/s Leitungen. Die Bandbreite war auf Anregung der britischen Gruppe gegenüber dem ursprünglichen Konzept deutlich erhöht worden [ Roberts II ], [ Leiner ].

Trotz des militärischen Hintergrundes waren die Entwicklungsarbeiten am ARPANET nicht "classified", sondern (fach)öffentlich, was die Einbeziehung von und Wechselwirkung mit anderen am Thema arbeitenden Gruppen erleichterte und die Entwicklung sicher beschleunigt und verbessert hat (s. z.B. die kanadischen und westeuropäischen RFC-Empfänger in ([ NWG ] S. 5f)).

War das nun entstehende ARPANET als Vorläufer des Internet militärisch oder nicht? Streng genommen: nicht militärisch, da die früheren Arbeiten am RAND nicht in die ursprüngliche Konzeption des ARPANET einflossen, insbesondere nicht unter der Fahne von "command and control".

Barans packet switching Konzepte sind allerdings klar militärisch motiviert, und da sie im ARPANET ebenso wie im Folgenetz Internet Anwendung fanden, waren bzw. sind diese "indirekt militärisch", da sie diese Technologie benutzen. Paradoxerweise war Baran selbst das Konzept deshalb sehr wichtig, weil ein erstschlagsresistentes militärisches Kommunikationsnetz einen Atomkrieg insgesamt unwahrscheinlicher macht - egal welche Atommacht es als erstes implementiert [ Baran III ], deshalb hatte er es ja auch publiziert [ Baran II ]. Und zwar wegen der dadurch zu erwartenden "Kosten" eines Erstschlags für den Angreifer, da dieser einen Gegenschlag des Angegriffenen nicht mehr durch das Ausschalten ein(ig)er Zentrale(n) sicher verhindern könnte. Nicht weniger paradox, dass die dafür wichtigen Prinzipien der Dezentralität und Redundanz selbst für anarchistische Gesellschaftsvorstellungen wichtig sind.

Von größerer praktischer Relevanz als solche Grundsatzdiskussionen dürfte aber sein, dass der cash flow für das ARPANET von der Militärbehörde ARPA kam. Den beteiligten Wissenschaftlern kann man diese Verstrickung insofern nicht vorwerfen, als dass es keine Alternative zur Finanzierung ihrer Ideen einer räumlich verteilten Computernutzung gab. Die im kommerziellen Bereich thematisch Zuständigen, die Telefongesellschaften, waren nicht mobilisierbar. Monopolisiert-verknöchert steckten sie im alten mentalen Bezugssystem der Leitungsvermittlung fest. Packet switching hätte für die Telefongesellschaften eine Revolution dargestellt.

1969: Die ersten 4 Knoten des Arpanet - Quelle: http://www.computerhistory.org

Das ab 1969 implementierte ARPANET war also der erste praktische Versuch eines WAN (wide area network) auf der Basis von packet switching. (Zumindest der erste öffentlich bekannte Versuch: Baran [ Baran III ] erwähnt einen erfolgreichen, geheimen militärischen Test mit einem Dutzend Funkstationen, vmtl. Anfang oder Mitte der 1960er. Dabei, so sagt er, wurde ein (digitales) Fernschreibsignal durch Frequenzmodulation unhörbar in ein ansonsten amplitudenmoduliertes Funksignal eingebracht und unbemerkt mitübertragen - ein genialer hack.)

Zunächst galt es, das ARPANET überhaupt funktionsfähig und benutzbar zu machen, was durchaus (ebenso wie die Arbeit am NPL) als Pionierleistung bezeichnet werden kann. Die von BBN gelieferten IMPs boten die Transportmöglichkeit für die Datenpakete. Für die Nutzung des Netzes durch die AnwenderInnen fehlten noch die host-to-host Protokolle. Die Datenpakete müssen nicht nur zum Zielrechner transportiert werden, sondern es muss auch angegeben werden welches der dort laufenden Programme das jeweilige Paket erhalten soll. Die überregionale, wechselseitige Nutzung von Computerkapazitäten und Programmen zwischen allen vom ARPA geförderten Gruppen war schließlich der proklamierte Sinn des ARPANET.

Im Unterschied zur Gruppe am NPL waren die am ARPANET beteiligten Gruppen räumlich weit verteilt und ohne übergeordneten "Chef", der das genaue weitere Vorgehen dekretiert hätte. So organisierten die beteiligten Gruppen den zur Spezifikation und Implementierung der host-to-host Protokolle erforderlichen Diskurs selbst, der im April 1969 (also Monate vor der Lieferung der ersten IMPs) zu den ersten RFCs (request for comment) führte. Zur Veranschaulichung sei der paradigmatische RFC3 zitiert:

"The Network Working Group seems to consist of Steve Carr of Utah, Jeff Rulifson and Bill Duvall at SRI, and Steve Crocker and Gerard Deloche at UCLA. Membership is not closed. [...] The content of a NWG note may be any thought, suggestion, etc. related to the HOST software or other aspect of the network. Notes are encouraged to be timely rather than polished. [...]

These standards (or lack of them) are stated explicitly for two reasons. First, there is a tendency to view a written statement as ipso facto authoritative, and we hope to promote the exchange and discussion of considerably less than authoritative ideas. Second, there is a natural hesitancy to publish something unpolished, and we hope to ease this inhibition." [ Crocker ]

"Die Netzwerk-Arbeitsgruppe (NWG) scheint aus Steve Carr aus Utah, Jeff Rulifson und Bill Duvall am SRI, und Steve Crocker und Gerard Deloche am UCLA zu bestehen. Die Gruppe ist offen für weitere Mitglieder. [...] Der Inhalt einer NWG-Mitteilung kann jeder Gedanke, Vorschlag etc. sein, der sich mit der HOST Software oder anderen Aspekten des Netzwerks beschäftigt. Statt perfekter Formulierungen sollen Mitteilungen besser frühzeitig erfolgen. [...]

Diese Standards (oder das Fehlen derselbigen) sind aus 2 Gründen explizit formuliert worden. Erstens gibt es die Tendenz geschriebene Aussagen schon wegen der Schriftform als maßgeblich anzusehen und wir hoffen den Austausch von und die Diskussion vor allem über nicht so maßgebliche Ideen zu fördern. Zweitens gibt es eine natürliche Zurückhaltung etwas noch nicht perfektes zu veröffentlichen und wir hoffen diese Hemmung abzuschwächen.

Dieser offene, anti-autoritative Stil dürfte (neben dem ARPA cash flow;-) wesentlichen Anteil an der nun beginnenden Erfolgsgeschichte haben. Diese führt vom NCP (network control program) über Applikationsprotokolle wie telnet (ab RFC97) und ftp (ab RFC114), die heute noch in Gebrauch sind. Und kaum dass ARPANET funktionierte und langsam wuchs, wurden neue Anwendungen ersonnen, allen voran e-mail (ab RFC196), welche für den Austausch unter den Beteiligten und damit die weitere Evolution des Netzes katalytisch war.

Im Oktober 1972 wurde das ARPANET auf der ersten internationalen Konferenz über Computerkommunikation in Washington D.C. öffentlich demonstriert. Mit nicht weniger als dem Echtzeitzugriff vom Konferenzort auf über 40 entfernte hosts (s. RFC372, RFC384) und deren Programme über das ARPANET. Es folgt 1973 die Internationalisierung durch eine Verbindung nach Großbritannien zum UCL (University College London), ein technischer und (anti)bürokratischer hack [ Kirstein ].

Ebenfalls 1973 beginnen bereits die Arbeiten an der nächsten Protokollgeneration namens TCP (transmission control protocol). Sinn des neuen Protokolls war die Möglichkeit, Verbindungen zwischen Computern in verschiedenen Netzen herstellen zu können, insbesondere sollte das ARPANET mit Satelliten- und Bodenfunknetzen verbunden werden, was natürlich auch für militärische Anwendungen und damit die Geldgeber interessant war. Ebenso von Funknetzen inspiriert war die gleichzeitige Arbeit am Ethernet, der noch heute vorherrschenden Technik für lokale Netze (LANs).

Aus beiden Entwicklungen geht schließlich 1978 TCP/IP Version 4 (RFC790 ff) hervor. TCP/IP abstrahiert von den zugrunde liegenden Transportnetzen um das Zusammenschalten intern ganz verschieden strukturierter Netze zu ermöglichen. Dazu wurden alle Funktionen außer dem reinen Transport der Pakete vom Netz in die Software der hosts verlagert. IPv4 ist die heute noch überwiegende Protokollfamilie im Internet. Im Laufe des Jahres 1982 wird das ARPANET selbst komplett von NCP auf TCP/IP umgestellt. Vom Department of Defense (US Kriegsministerium) wird es als Standard bei der Beschaffung von Computerausrüstung verwendet.

BSD-Daemon - Nicht nur Linux hat sein Maskottchen, Copyright 1988 by Marshall Kirk McKusick

1983 erscheint BSD (Berkeley Software Distribution), ein frei verfügbares Unix Betriebssystem, in der Version 4.2. In diese ist - gefördert von der ARPA - TCP/IP integriert worden. Die inter-Netzwerkfähigkeit war Bestandteil des Betriebssystems geworden. Damit konnte sich internet Technologie in akademischen Kreisen schnell verbreiten.

Parallel zum ARPANET hatten sich auch international diverse paketorientierte Netzinfrastrukturen gebildet. Auch in den USA selbst kam nur ein kleiner, eher elitärer Teil aller Forschungs- und Bildungseinrichtungen in den Genuss einer Anbindung ans ARPANET. So gab es weltweit viele Anstrengungen zur Ermöglichung von vernetztem Datenaustausch und darauf basierender Kommunikation zwischen Einrichtungen und später, mit dem Aufkommen von PCs (personal computer), auch Einzelpersonen. Dies wäre (mindestens) eine weitere Geschichte wert, wir begnügen uns aus Platzgründen mit Stichworten wie Tymnet, Cyclades, Telenet, X.25, uucp, Usenet, BITNET, CSNET, FidoNet.

Ab 1981 förderte die NSF (National Science Foundation) das CSNET (Computer Science Network), welches nicht durch ARPA geförderte Einrichtungen miteinander und dem ARPANET verband. Dazu wurden zunächst e-mail gateways genutzt. Gateways ermöglichen die Datenübertragung zwischen hosts die verschiedene Protokolle benutzen. Das Gateway 'übersetzt' ein Protokoll in ein anderes. Später wurde im CSNET dann auch TCP/IP verwendet, seitdem der de facto Standard des inter-networking.

Über das CSNET schließen sich auch international weitere Einrichtungen an das frühe Internet an, vergrößern es damit vor allem auch personell und machen internet-Technologie bekannter. Nicht nur technisch, auch organisatorisch ist ein heterogenes internet entstanden - das Internet.

NSFNET Backbone 1986

NSFNET Backbone 1992

In einem nächsten Schritt fördert die NSF ab 1985 ein TCP/IP basiertes Netz (NSFNET) zwischen Supercomputerzentren. Dieses Netz konnte von den angeschlossenen Netzen (wie CSNET) kostenlos zum Zugriff auf die Supercomputer genutzt werden. Ein solches Hauptnetzwerk, das alle Teile des internet miteinander verband wurde internet-backbone genannt. Heutzutage wird diese Bezeichnung benutzt, um den „Kern“ des aktuellen Internet zu beschreiben.

Es beginnt ein deutliches Wachstum des jungen Internet, indem sich an die vom NSF geförderten regionalen Netzwerke immer mehr lokale Netzwerke anschließen. Das eigentliche ARPANET ist nur noch ein kleiner Teil des Internet. Die militärischen hosts wurden 1983 sicherheitshalber in ein separates MILNET ausgelagert. 1990 wird das ARPANET endgültig außer Betrieb genommen.

1991 wird der NSFNET backbone von 1,5 Mb/s auf 45 Mb/s Verbindungen aufgerüstet, ein Novum für packet switching. Ein weiterer Meilenstein ist der erste operative Einsatz des Routing-Protokolls BGP (border gateway protocol). Die Einführung von BGP war nötig, um das routing für die stark wachsende Zahl direkt und indirekt angeschlossener Netze noch handhaben zu können. 1995, am Ende des NSFNET waren bereits über 50.000 Netze aus über 90 Ländern angeschlossen (NSFNET, S. 33).

Der Vollständigkeit halber sei erwähnt, dass es direkte Internet-Konnektivität in der BRD seit 1989 gibt und dass die folgende Durchsetzungsgeschichte von TCP/IP zunächst dem Muster "Kampf der Infizierten gegen die Institutionen" folgt (s. [ Kalle ]).

Die Förderung einer eigenen akademischen Netzinfrastruktur durch die NSF war zeitlich und vom Fördervolumen begrenzt. Die regionalen Netze sollten bzw. mussten auch andere Finanzierungsquellen aufbauen.

Da das NSFNET backbone des damaligen Internet war, galten seine Nutzungsbedingungen (s. [ NSF ], S. 79f) auch für alle indirekt angeschlossen Netze, da deren traffic (Datenverkehr) notwendigerweise meistens über diesen backbone ging ([ NSFNET ], S.34). Darin waren kommerzielle Aktivitäten wie Werbung untersagt - der backbone wurde ja aus Steuermitteln finanziert. Erst 1991 wurden die Nutzungsbedingungen geändert, und das NSFNET auch zur Nutzung für wissenschaftliche Zwecke durch kommerzielle Forscher freigegeben (vgl. [ CNI ] und [ NSF ], S. 79) und kommerzieller transit traffic gegen Entgelt zugelassen ([ NSF ], S. 23).

Der zunehmende kommerzielle Druck, das Internet auch fürs Business nutzen zu können, führte zu Spannungen mit der akademischen Nutzergemeinde und staatlichen Stellen ([ NSFNET ] S. 31f). Dies hätte sich vmtl. früher oder später in einem separaten kommerziellen internet manifestiert, wenn die NSFNET-Administration nicht sowieso schon durch die Involvierung von MCI und IBM auf Kommerzkurs gewesen wäre ([ NSFNET ], S. 7ff).

Nach zweimaliger Verlängerung der Förderung wird der NSFNET backbone 1995 schließlich stillgelegt. Mittlerweile existierten auch kommerzielle Provider, die den traffic transportieren konnten. Zu Konzepten und Details der Ablösung des NSFNET siehe ([ Halabi ], S. 7-25).

Die Funktion das Internet zusammen zu halten, wurde an die kommerziellen Betreiber übergeben ([ NSFNET ] S. 40ff). Dafür wurde ein neues Element in die Internetarchitektur eingeführt, das bis heute üblich ist: die Internetknoten, auch IX oder NAP genannt (internet exchange bzw. network access point).

Ein IX ist ein Gebäude mit entsprechender Infrastruktur, an denen die (überwiegend kommerziellen) Internet Provider untereinander traffic austauschen können ("peering"). Falls das Zielnetzwerk nicht direkt über das IX, zu dem ein Provider eine Verbindung hat, erreichbar ist, kann er traffic an überregionale Netzbetreiber übergeben ("transit"). Es gibt zur Zeit weltweit über 100 solcher Internet-Knotenpunkte. Der größte in der BRD ist das DE-CIX in Bankfurt. Durch den zunehmenden traffic von und nach Osteuropa ist das DE-CIX mittlerweile einer der weltgrößten Internet-Knotenpunkte. Dort sind alle größeren Provider vertreten, mit erwähnenswerter Ausnahme des Erbmonopolisten Telekoma (s. [ DE-CIX ]).

Überregionale Netzbetreiber haben heute eigene nationale, internationale oder gar interkontinentale backbones, so dass es heute diverse backbones im Internet gibt, nicht mehr nur einen wie zu Zeiten des NSFNET. Bei aller gebotenen Kritik am Kommerz ist das ein Vorteil für die Ausfallsicherheit und ein (weiterer) antimonopolistischer Aspekt des Internet.

Der Kommerzialisierung der Infrastruktur folgte zunächst die Kommerzialisierung der Dienste. Mit dem Wegfall der Nutzungsbedingungen des NSFNET begann die Kommerzialisierung der Inhalte. Schon 1989 wurden erste Mailgateways zwischen dem Internet einerseits und MCI Mail und CompuServe andererseits eingerichtet.

Im gleichen Jahr startete der erste kommerzielle Provider (world.std.com), der Kunden per Modemeinwahl Zugang zum Internet ermöglichte.

Die Kommerzialisierung der Inhalte wurde (unbeabsichtigterweise) katalysiert durch eine Innovation aus dem wissenschaftlichen Bereich, dem world wide web ("WWW"). 1990 wurde am Genfer Hochenergiephysikzentrum CERN die erste Websoftware entwickelt und genutzt, um auf heterogene Dokumenten- und Datenbestände mit einer einheitlichen Benutzeroberfläche zuzugreifen. Grundideen sind Hypertext, Trennung von Datenformaten und ihrer Darstellung, Dezentralität, Erweiterbarkeit [ Berners-Lee ].

Um Hypertext, also miteinander verknüpfte Dokumente, dezentral aufbauen zu können, braucht man eine Identifikationsmöglichkeit für Dokumente. Außerdem ist eine darauf beruhende Zugriffsmöglichkeit erforderlich, die bei Vorlage der Dokumentenkennung das Dokument beschafft. Für beides bot das Internet eine gute Grundlage, auch weil mit dem DNS bereits ein Namensraum für den Echtzeitzugriff auf Netzwerkressourcen vorhanden war. Die offene internet Architektur bot Möglichkeiten für die Kommunikation zwischen dem Programm des Benutzers ("browser") und den Servern bestehende Protokolle zu nutzen (z.B. ftp). Es konnte aber auch ein für Hypertext spezialisiertes Protokoll entwickelt werden (http, hypertext transfer protocol). Für das Format der Hypertextdokumente wurde auf einen vorhandenen ISO Standard zurückgegriffen, nämlich SGML (standard generalized markup language), um das im WWW noch heute verwendete HTML (hypertext markup language) zu spezifizieren.

Graphische oder gar multimediale Inhalte waren zwar im Konzept des WWW vorgesehen ("Hypermedia"), aber zunächst von geringer Bedeutung im Vergleich zu textuellen Informationen und ihrer Verknüpfung. Das änderte sich, als auch für mainstream PCs graphische Webbrowser verfügbar wurden, insbesondere 1993 das freie Mosaic, später von den gleichen Entwicklern das kommerzielle Netscape (heute wieder "befreit" als Mozilla/Firefox). Damit konnten auch Menschen ohne Kenntnis der internet Protokolle und ihrer jeweiligen Nutzung auf Ressourcen im Internet zugreifen - mit der Maus auf die Hyperlinks zu klicken reichte bereits aus zur Navigation in diesem ständig wachsenden Informationsuniversum namens WWW. So wie e-mail die sog. Killerapplikation des frühen ARPANET und der späteren Zusammenschaltungen verschiedener Netze war, so wurde das WWW die Killerapplikation des entwickelten Internet. Die neue Qualität des WWW, die Verknüpfung der Inhalte und der leichte Zugang zu diesen, ist eine konsequente Weiterentwicklung des Internetprinzips, nämlich der beliebigen Verbindungen zwischen angeschlossenen Rechnern, auf die Ebene der Inhalte.

Das WWW, eigentlich nur ein Dienst unter vielen im Internet, führte zu einem enormen quantitativen Wachstum des Internet, da sich nun auch die gesellschaftlich leider übliche Rollenverteilung von Konzern und Konsument abbilden ließ. Die Integration von Graphiken und Fotos in den Hypertext ermöglichte dann auch das Angebot von virtuellen Hochglanzprospekten und Illustrierten für die nun immer mehr ins Internet strömenden "Normalos".

Mit mehr verfügbarer Bandbreite ließen sich auch Audiodaten und bewegte Bilder integrieren, sodass das WWW mittlerweile auch als Ersatz für Radio und Fernsehen dient - mit dem Vorteil, von den festen Programmen der Sender unabhängig zu sein, also jederzeit auf beliebige der im WWW angebotenen Inhalte zugreifen zu können. Die scheinbar kostenlose Selbstberieselung im WWW zahlt der Surfer durch ein Bombardement mit Werbebotschaften und der Erfassung seiner Nutzungsdaten. Dass die staatlich ermächtigten Wegelagerer von der GEZ auf internetfähige PCs nun auch noch eine "Gebühr" für die von Anderen erbrachten Leistungen kassieren dürfen, ist ein ironisches Sahnehäubchen auf der Torte des frisch gekürten Massenmediums Internet.

Mit den Konzernen kamen auch die Markennamen ins Internet, und damit der Streit um Domainnamen. Im Internet wurden sie ursprünglich nur als Gedächtnisstütze für Menschen eingeführt. Es gab nur die einfachst mögliche Regelung zur Verteilung der Domainnamen: wer zuerst kommt, mahlt zuerst. Damit die Konsumenten aber möglichst schnell ohne Umwege ihre Nase an der virtuellen Schaufensterscheibe des Konzerns plattdrücken können, hat dieser ein Interesse, dass der zugehörige Domainname dem Markennamen entspricht (einer der ersten Fälle war 1994 mtv.com [ McKenna ]). Zur Durchsetzung dieses kommerziellen Interesses konnten die Juristen nun auch das Internet zu ihrem Herrschaftsbereich erklären.

So fehlte nicht viel, bis auch die staatlichen Gesetzgeber merkten, dass sie sich dort breit machen können. Ja sogar müssen, um der Gesellschaft mögliche rechtsfreie Räume, insbesondere eine eigene Öffentlichkeit, zu nehmen und obendrein ihre staatlichen, bisweilen totalitären Kontroll- und Überwachungsgelüste mit digitaler Perfektion umsetzen zu können (Stichworte: Telekommunikationsüberwachungsverordnung, Vorratsdatenspeicherung, China). Denn im Laufe der Geschichte des WWW ist nicht nur der Konsum von Inhalten einfacher geworden, sondern auch die Möglichkeiten, selbst zu publizieren.

We reject: kings, presidents and voting.

We believe in: rough consensus and running code.

Wir lehnen ab: Könige, Präsidenten und Abstimmungen

Wir glauben an: informellen Konsens und funktionierenden Code.

Die Bedeutung von Standards bei Kommunikationsprotokollen ist so hoch einzuschätzen wie die von Normen in der industriellen Produktion oder von Containern im Welthandel, also essentiell für die Zusammenarbeit organisatorisch und räumlich getrennter Beteiligter. Die oben bereits erwähnten herstellerunabhängigen Standards des Internet werden überwiegend von den Arbeitsgruppen der Internet Engineering Task Force (IETF) entwickelt.

Entgegen den insbesondere nationalen Standardisierungsgremien hat die IETF streng genommen noch nicht einmal den Status einer Organisation - sie hat keine Mitglieder, sondern "nur" individuelle Teilnehmer. Jede/r Interessierte kann sich auf den Mailinglisten der IETF und ihrer Arbeitsgruppen eintragen und mitarbeiten. Ebenso offen sind die dreimal jährlich stattfindenden Arbeitstreffen. Die Mitarbeit ist freiwillig und unbezahlt. Der auf den ersten Blick erstaunliche Ertrag an Standardisierungsleistung der IETF community (siehe die Liste der RFCs) hat als Grundlage natürlich die technische Kompetenz der Beteiligten, aber auch die weitgehende Abwesenheit von Anzugträgern ([ Hoffman ], S. 16) ist sicher hilfreich. Statt derer scheint Idealismus im Spiel zu sein: "The IETF community wants the Internet to succeed because we believe that the existence of the Internet, and its influence on economics, communication, and education, will help us to build a better human society." (Die IETF-Gemeinschaft will dass das Internet erfolgreich ist, weil wir glauben, dass die Existenz des Internet und sein Einfluss auf Ökonomie, Kommunikation und Bildung uns helfen wird eine bessere menschliche Gesellschaft aufzubauen.) ([ Alvestrand ], S. 2).

Neben Offenheit und Freiwilligkeit sind noch mehrere Aspekte der IETF Arbeit methodisch interessant. Zunächst die klar zu formulierenden Zielvorgaben für die Arbeitsgruppen sowie ihre zeitliche Befristung. Es sollen ja aktuelle Probleme und Anforderungen im Internet behandelt werden - für Grundlagenforschung gibt es die Internet Research Task Force (IRTF). Der vergleichsweise knappe Zeitrahmen bevorzugt - im Unterschied zu den bisher üblichen Standardisierungsverfahren - Entwicklungen von eher knappen, doch dafür erweiterbaren Standards, die spätere Entwicklungen nicht vorwegnehmen, aber ermöglichen. Die Arbeitsgruppen der IETF haben zwar einen koordinierenden Vorsitzenden, aber Entscheidungen werden in einem informellen Konsens gefällt ("rough consensus"). Erst wenn (fast) alle Teilnehmer die Gegenargumente für entkräftet halten, kann eine technische Lösung empfohlen werden. Das verschafft den technischen Argumenten Vorrang vor Taktiererei oder sonstigen (mono-)politischen Interessen. Damit schließlich eine Empfehlung den Status eines Standards erlangen kann, müssen mindestens zwei unabhängige Implementierungen vorliegen, die zusammen funktionieren und damit einen praktischen Nachweis für die Tauglichkeit des Standards darstellen.

Der offene Standardisierungsprozess im Internet und dessen Entwicklung vom frühen ARPANET und seinen ersten RFCs (als die Network Working Group eine Handvoll Aktiver zählte, s. das Zitat von RFC3 oben) zur heutigen IETF mit über 100 Arbeitsgruppen, über 1000 Teilnehmern auf Arbeitstreffen und insgesamt über 5000 publizierten RFCs ist sicher einer der wichtigeren Gründe, warum wir (d.h. diejenigen von uns, die Datennetzwerke nutzen) in einer Internet-Welt leben und nicht in einer ISO/OSI Welt.

Nicht nur der Vollständigkeit halber sei erwähnt, dass die IETF zwar eher als community oder Prozess denn als Organisation bezeichnet werden kann, aber dass sie selbst(-)organisiert ist und in (formale) organisatorische Zusammenhänge eingebettet ist. Dies sind (in aufsteigender Reihenfolge) die Internet Engineering Steering Group (IESG), das Internet Architecture Board (IAB) und schließlich die Internet Society (ISOC), s. [ Hovey ]. Die ISOC hat über 80 Organisationsmitglieder und über 28000 individuelle Mitglieder. Neben der organisatorischen Rahmenstruktur für den Standardisierungsprozess agiert sie u.a. als Fürsprecherin eines ungehindert zugänglichen, unzensierten Internet auch auf globaler politischer Ebene, etwa den UN-Projekten WSIS (World Summit on the Information Society) und IGF (Internet Governance Forum).

Für das Funktionieren des Datenaustauschs zwischen den Systemen im Internet braucht es zunächst standardkonforme Software. Außerdem ist aber auch die konkrete Zuordnung verschiedener operativer Parameter erforderlich.

Die wichtigste dieser Zuordnungen ist die einer IP-Adresse. Dabei muss sichergestellt werden, dass jede Adresse zu einem gegebenen Zeitpunkt höchstens einmal vergeben ist. Das entspricht dem Problem der Vergabe von Telefonnummern im Telefonnetz. Es ist klar dass nicht zwei verschiedene TeilnehmerInnen die gleiche Nummer haben sollten.

Das zweitwichtigste dieser Probleme ist die Zuordnung der - im Vergleich zu den IP-Adressen gedächtnisfreundlichen - Domainnamen.

Die "Oberhoheit" über die Zuordnung der Adressen und Domainnamen hat die IANA (Internet Assigned Numbers Authority), die bis 1998 im Wesentlichen aus Jon Postel, einem Internet-Urgestein bestand. Die IANA wurde dann Teil der 1998 gegründeten ICANN (Internet Corporation for Assigned Names and Numbers), mit Hauptsitz in Kalifornien. ICANN ([ ICANN ], [ Hofmann ]) ist formal eine gemeinnützige Firma ("nonprofit public benefit corporation"), die frühere Verträge der US-Regierung mit akademischen und kommerziellen Stellen zur Koordination der Parametervergabe fortführte. Auch wenn die US-Regierung als historischer Sponsor des Internet damit formal diese Kontrolle an eine nicht-Regierungs-Organisation abgab, ist dieser Abgabeprozess auch nach 10 Jahren noch nicht abgeschlossen.

Die nennenswerteste Änderung, die durch ICANN erzielt wurde, ist eine weitgehende Auflösung des früheren NSI Monopols bei Domainnamen, die aber schon vor der Institutionalisierung der ICANN in Angriff genommen worden war. Etwas vereinfacht - und im Gegensatz zu der populären Formulierung "Weltregierung des Internet" - kann man ICANN beschreiben als (Selbst-)Regulierungsinstanz der Domainnamenwirtschaft unter Aufsicht des US-Handelsministeriums. Dabei hat das, was da bewirtschaftet wird, nämlich der Domainnamensraum, von sich aus zunächst gar keine Warenform, sondern musste durch juristische Verknappungskonstrukte (Markennamen, geistiges Eigentum) erst einmal entsprechend eigentumsförmig zugerichtet werden (s.o. mtv.com). Die im Jahre 2000 praktizierte Direktwahl von je einem ICANN-Direktor je Kontinent durch die InternetnutzerInnen blieb auch ein einmaliges Ereignis und wurde wegreformiert. Die Gründe dafür kann man in [ Müller-Maguhn ], der "Regierungs erklärung" des damals von den europäischen NutzerInnen gewählten Direktors, erahnen:-)

Ein derartiger kommerzieller Abgriff wie bei den Domainnamen ist mit den - technisch grundlegenderen - IP-Adressen glücklicherweise nicht geschehen. Hier erfolgt die Vergabe in etwa kontinentweise organisiert durch sog. RIRs (Regional Internet Registries), in Europa das RIPE NCC [ RIPE ]. Sie finanzieren sich durch Umlagen auf ihre Mitglieder, die ISPs (Internet Service Provider), welche auch gemeinschaftlich die jeweiligen Vergaberichtlinien in ihrer Region bestimmen. Ein ähnliches Selbstverwaltungsmodell findet sich übrigens auch bei der für die Vergabe von .de Domains zuständigen Organisation DENIC, einer Genossenschaft.

Die gravierenden Unterschiede zwischen den Regulationsprozessen bei ICANN (politisch-wirtschaftlich) und insb. den RIRs (technisch-wirtschaftlich) haben einen technischen Angelpunkt: die Rootserver des DNS, deren operative Kontrolle die letztlich wirkende Autorität über den Domainnamensraum darstellt. Die Nutzung von IP-Adressen hingegen erfordert zwar Eindeutigkeit und von daher eine koordinierte Vergabe, aber operativ keine zentralen Strukturen ( s.o.).

Wie im Internet das Problem gelöst wird, die gegenseitige Erreichbarkeit von z.Z. vmtl. über 500 Millionen hosts [ ISC ] ohne zentrale Instanzen herzustellen, ist nicht nur von technischem Interesse. Ein host ist entweder direkt in einem LAN oder durch Zugang per Einwahl (Modem, ISDN) bzw. Zugangskonzentrator (DSL, TV-Kabel) Teil eines IP-Subnetzes. Außerhalb dieses Subnetzes muss nichts über die einzelnen hosts des Subnetzes bekannt sein, sondern nur über die Erreichbarkeit des gesamten Subnetzes. Subnetze sind - was die Verbindungen zum Internet angeht - Teil einer Organisation, die sich um diese Verbindungen kümmert. Eine Gruppe von Subnetzen, die eine gemeinsame Administration hinsichtlich ihrer Verbindungen ins Internet hat, wird Autonomes System ("AS") genannt. Meist ist dies ein ISP, aber auch Universitäten oder größere Firmen haben bisweilen eigene Verbindungen ins Internet.

Die AS tauschen mit ihren jeweiligen AS-Nachbarn, zu denen sie eine Verbindung haben, Informationen über die Erreichbarkeit von Subnetzen aus. Zunächst natürlich über ihre jeweils eigenen Subnetze, wobei deren Informationen vorher nach Möglichkeit zu größeren Blöcken aggregiert werden. Die Adressvergabestrategien der RIRs ( s.o.) zielen u.a. darauf ab, solche Aggregierungen zu ermöglichen, um dadurch die Menge im Internet zirkulierender routing Informationen so gering wie möglich zu halten. Des Weiteren werden aber auch routing Informationen, also Adressblöcke und der Weg zu ihnen, von den Nachbarn an deren Nachbarn weitergegeben, und das tun diese Nachbarn wiederum auch etc., sodass sich über die jeweiligen Nachbarschaftsverbindungen die Information über die Erreichbarkeit eines gewissen Subnetzes (bzw. des ihn enthaltenden Adressblocks) lawinenartig im gesamten Internet verbreitet.

Die zu übertragenden Datenpakete schließlich, z.B. für eine nameserver Abfrage oder die Übertragung einer Webseite, können dann genau auf dem umgekehrten Weg wie die routing Informationen, die den Zieladressen der Pakete entsprechen, ans Ziel gelangen. Die Einheit - d.h. die vollständige wechselseitige Erreichbarkeit - des gesamten Internet basiert also letztlich nur auf bilateralen Vereinbarungen zwischen je zwei AS zur Herstellung einer Nachbarschaftsbeziehung.

Jedes AS muss per Definition mindestens zwei Nachbarn haben, denn ansonsten wären seine Subnetze hinsichtlich des externen routings Teil seines einzigen Nachbarn und damit Teil von dessen AS. Dieses Grundkonzept der Redundanz wirkt auf verschiedenen Ebenen des Internet und führt damit trotz und wegen der Größe des Internet zu dessen erstaunlicher Stabilität.

Durch die Kommerzialisierung des Internet sind die Nachbarschaftsbeziehungen überwiegend kommerziell und meist entweder eine Kundenbeziehung oder eine peering-Beziehung. Im ersten Fall kauft das kleinere AS (Kunde) vom größeren AS (Provider) die Leistung, dass Kundenpakete durch das Netz des Providers transportiert werden und darüber hinaus zum Rest des Internet (transit). Damit dieser Provider die Kundenpakete (und seine eigenen) auch an den Rest des Internet weiter transportiert bekommt, ist er selbst wiederum (transit-)Kunde eines oder mehrerer noch größerer AS und/oder er kann Teile des Internet durch peering-Beziehungen zu - meist etwa gleich großen - AS erreichen. Diese kommerzielle Struktur des Internet führt allerdings rein technisch gesehen zu suboptimalem routing. Dies wird kompensiert zum einen durch die diversen IX ( s.o.), an denen die Provider mit vielen anderen Providern kostengünstig peering-Beziehungen aufbauen können, und durch die während der New Economy[tm] aufgebauten Überkapazitäten bei den Glasfaserverbindungen [ Bleich ]. Durch deren Geschwindigkeit wird auch ein suboptimales routing für die NutzerInnen nicht spürbar, im Gegensatz zum sog. World Wide Wait der 1990er Jahre.

Außer den erwähnten Glasfaserstrecken besteht der "Körper" des Internet noch aus Rechenzentren sowie auf der anderen Seite den Anschlussleitungen zu den Endkunden und deren hosts. Die landgebundenen überörtlichen Glasfaserverbindungen gehören Wege(rechts)inhabern z.B. entlang von Pipelines, Überlandleitungen, Auto- und Eisenbahnen, also im Wesentlichen Energieversorgungs- und Telekommunikationskonzernen. Übertragungskapazitäten werden an Transportnetzbetreiber ("Carrier") und Internetprovider weiterverkauft. Die Rechenzentren des Internet befinden sich meist unmittelbar bei einem IX oder umfassen einen solchen, weil an einem IX Glasfasern verschiedener backbones zusammenlaufen und Bandbreite zum Rest des Internet dort kostengünstig zu bekommen ist. Diese Rechenzentren bestehen aus Hunderten von 19-Zoll-Schränken, in denen wiederum jeweils Dutzende von Servern betrieben werden, sowie der zugehörigen unterbrechungsfreien Stromversorgung und Klimatisierung. Die Betreiber der Server mieten sich von den Betreibern der Rechenzentren Schränke oder Teile von Schränken um ihre Server unter stabilen Bedingungen und mit hoher Geschwindigkeit und großer Bandbreite im Internet zugreifbar zu machen. Verbindung zum Internet bekommen sie dort von einem im Rechenzentrum präsenten Provider oder, wenn sie selbst AS sind, durch die oben genannten transit- und/oder peering-Beziehungen zu mehreren dort präsenten Providern.

Soviel zu den "Dezentralen" des Internet, kommen wir zur Peripherie: an den Rändern des Internet befinden sich Privat- und Firmenkunden. Sie bezahlen Zugangsanbieter ("access provider") für die Bereitstellung einer Verbindung zum Internet um dann (üblicherweise) die von Servern angebotenen Dienste zu nutzen. Wenn Firmen selbst Dienste anbieten, sei es für die Internet-Öffentlichkeit oder zum Zugriff von Außenmitarbeitern oder Filialen auf das interne Netz, dann lassen sie sich meist über andere (symmetrische) Leitungstypen anbinden. Büros oder Privatpersonen die nur auf Dienste zugreifen werden mit billiger vermarkteten, asymmetrischen Leitungen angebunden.

Die Leitungen am Rande des Internet, die sog. letzte Meile zu den Endkunden, gehören in der BRD den Nachfolgern des Postmonopols, also der Telekoma und den Betreibern von Kabelfernsehnetzen. Aber auch die Zugangsmöglichkeit über Mobilfunknetze sei erwähnt. Im Falle der Kupferadern zu den Endkunden muss der Erbmonopolist Telekoma die Konkurrenzkonzerne zu staatlich von der sog. Bundesnetzagentur definierten Konditionen die Kupferadern nutzen lassen. Die über Zugangsleitungen ans Internet angeschlossenen hosts schließlich gehören den jeweiligen Endnutzern.

Die für das Internet wohl relevantesten Kapitalakkumulationen sind die in den Bereichen backbone-Leitungen, Endkundenanschlussleitungen, Hersteller von Übertragungstechnik und Routern für Carrier und Provider, Dienste für Endkunden (z.B. Google, werbefinanzierte Mailprovider), Softwarehersteller für Endkunden (Micro$oft). Diesen steht - in der IT-Branche traditionell - keine nennenswerte gewerkschaftliche Organisierung der Werktätigen gegenüber.

Der enorme quantitative Erfolg des Internet und sein schnelles Eindringen in die Gesellschaft hängen eng mit der kapitalistischen Organisierung des Internet seit Anfang der 1990er Jahre zusammen. Dass das Internet für die kapitalistische Verwertung relevant wurde, liegt zum einen in seiner Neutralität und Integrationsfähigkeit begründet, die einen Raum schufen, in dem auch Konkurrenten koexistieren konnten und damit zumindest indirekt kooperierten. Außerdem erhöhte jedes neu assimilierte Netz die Attraktivität des gesamten Verbundes, des Internet. Die daraus resultierende Dynamik und der dank WWW drastisch gestiegene Gebrauchswert für die EndnutzerInnen führten Mitte der 1990er zur "Kapitulation" der bis dahin isolierten (online-)Giganten wie CompuServe, AOL, Telekoma, Micro$oft in Form ihrer Teilnahme am Internet.

Mittlerweile steht das Internet alternativlos im Bereich der elektronischen Geschäftskommunikation da, was einen hohen Erwartungsdruck auf sein Funktionieren und damit insb. die Anbieter der Verbindungen und der geschäftlich genutzten Dienste ausübt. Dies führt bei den operativ relevantesten IP-Technologien zu einem - verständlichen - Konservatismus, der den dreifaltigen Innovationszyklus des Internet unterbricht: damit das quantitative Wachstum ( s.o) durch seine Möglichkeiten und Probleme ein qualitatives ( s.o.) hervorbringen kann, werden technische Innovationen entwickelt und standardisiert ( s.o.), die nun aber im Falle der operativen IP-Kerntechnologien höchstens peripher, aber nicht im Kern des Internet eingesetzt werden (zu Beispielen wie IPv6, multicast, QoS siehe [ Handley ]). Denn der dafür erforderliche Aufwand würde von einem kapitalistischen Internetunternehmen nur getrieben werden, wenn es dadurch entweder einen Marktvorteil größer als der Aufwand erzielen könnte, oder wenn es ohne die Innovation seine Wettbewerbsfähigkeit verlieren würde. Der erste Fall ist insofern unwahrscheinlich, als dass Veränderungen am Kern wegen der "Einheit des Internet" ja von allen daran Beteiligten umgesetzt werden müssten, also auch von den "Mitbewerbern", die dann aber den gleichen Wettbewerbsvorteil hätten, sodass er keiner mehr wäre.

Der erste Fall ist insofern unwahrscheinlich, als dass Veränderungen am Kern wegen der "Einheit des Internet" ja von allen daran Beteiligten umgesetzt werden müssten, also auch von den "Mitbewerbern", die dann aber den gleichen Wettbewerbsvorteil hätten, sodass er keiner mehr wäre. Der zweite Fall, also der Untergang eines Internetunternehmens wegen versäumter Innovation einer IP-Kerntechnologie, würde entweder dann eintreten, wenn die allermeisten der "Mitbewerber" den Innovationsaufwand betreiben würden, so dass bei einer vereinzelten Innovationsverweigerung nur ein geringer Schaden an der "Einheit des Internet" entstehen würde, der von den betroffenen Kunden des innovationsverweigernden Unternehmens durch deren zügigen Wechsel zu einem "Mitbewerber" geheilt werden würde. Dieser Fall ist theoretisch zwar durch eine Kartellbildung eines sehr großen Teils der am Kern beteiligten Unternehmen denkbar, aber praktisch wegen des vorhin behandelten Falles durch den im Endeffekt fehlenden Wettbewerbsvorteil unwahrscheinlich.

Es bleibt der Fall eines operativen Zusammenbruchs des Internet durch quantitatives Wachstum bei gleichzeitigem Ausbleiben dafür erforderlicher Innovation, was - mindestens - zu einer Schrumpfung des Internetmarktes führen würde. Historisches Kollapsbeispiel sind die Verstopfungszusammenbrüche des noch jungen Internet der 1980er Jahre.([ Handley ], S. 120) Durch die damaligen Eigenschaften des Kernprotokolls TCP führten Kapazitätsüberschreitungen zu einem kompletten Zusammenbruch, in etwa vergleichbar dem Problem in einem Stromnetz, wenn sich nach einem Ausfall bei Wiederkehr der Stromversorgung alle Geräte gleichzeitig ihren hohen Startstrom ziehen, was zu Überlastung und erneuter Abschaltung des Netzes führt. Seinerzeit konnten die akuten Probleme noch durch eine rückwärtskompatible Korrektur des TCP Protokolls und seiner Implementierungen gelöst werden. Aber schon dies war keine grundlegende Lösung mehr, da sie nur ein Protokoll betraf, welches zwar bisher den Großteil der Daten im Internet transportiert, aber z.B. für die heute zur Ausweitung der Kapitalverwertung angestrebten breitbandigen Echtzeitanwendungen (Stichwort technische Medienkonvergenz) technisch keine große Rolle spielt. Die letzte einschneidende Änderung am Kern des Internet geschah um 1993 ([ Handley ], S. 120f), als sich wegen des quantitativen Wachstums die Verfügbarkeit sog. Class B Adressblöcke erschöpfte und das routing im gesamten Internet auf CIDR (classless inter-domain routing) und damit BGP4 umgestellt werden musste. Dies war dadurch noch handhabbar, dass die Umstellung am Rande des Netzes rückwärtskompatibel gestaltet werden konnte und im Kern des Netzes keine hardware ausgetauscht werden musste, weil routing damals noch ohne Hardwareunterstützung beim forwarding auskam. Und Cisco, seinerzeit noch Monopolist in Sachen Internetrouter, hatte natürlich ein Interesse daran, seine proprietäre Routersoftware entsprechend zu ändern, um das weitere Wachstum "seines" Marktes zu ermöglichen.

Kapitalismusinduzierte Innovationsprobleme gibt es beim Internet aber nicht nur im physischen Kernbereich, sondern auch an den Rändern. Insbesondere die Unterteilung in zahlungskräftige Firmenkunden und Konsumentenmassen hat zu einer sehr weit gehenden Verwendung von NAT (network address translation) geführt, wodurch die beim Endkunden angeschlossenen Geräte keine vollwertigen hosts mehr sind, da der Endkunde von seinem Provider nur eine IP-Adresse zugeteilt bekommt, die sich die verschiedenen Geräte teilen müssen. Dadurch wird ein zentrales Paradigma eines internet - beliebige Verbindungen zwischen beliebigen hosts - gebrochen, was dann auch zu massiven Komplikationen bei oder gar zur Unmöglichkeit von etlichen Protokoll-Innovationen führt, insb. auch solchen, die einen direkten Datenaustausch zwischen Endnutzern ermöglichen, also ohne den Umweg über zentrale Server. Einen verwandten Paradigmenbruch stellen auch firewalls dar, die nur selektiv Verbindungen zulassen. Das der breiten Verwendung von firewalls zugrunde liegende Sicherheitsbedürfnis lässt sich auch als Kollateralschaden der kapitalistischen Kommerzialisierung verstehen, da mit dem Geld das Verbrechen ins Netz kam und die Monokultur bei der Endnutzersoftware (Micro$oft) in der Tat eine sicherheitstechnische Dauerkatastrophe darstellt.

Der Vollständigkeit halber sei zum Thema der kapitalistischen Innovationsdialektik noch daran erinnert, dass die letzte fundamentale, nicht rückwärtskompatible Innovation in der Geschichte des Internet der Umstieg von NCP auf TCP/IP war. Er wurde zum 1.1.1983 vom staatlichen Sponsor des ARPANET verordnet.

Quantitativ spielt der Staat im Internet heute keine so herausragende Rolle mehr wie in den militärisch-akademischen Phasen der Internetentwicklung ( packet switching bis NSFNET). In Europa sind die ehemaligen staatlichen Telekommunikationsmonopole im Zuge der Neoliberalisierung bzw. der Abwicklung des sog. Realsozialismus privatisiert worden. In der BRD gibt es z.Z. (2008) insg. noch 32% direkte und indirekte Staatsanteile an der Deutschen Telekom AG. Im staatlich finanzierten Wissenschaftsbetrieb gibt es eigenständige Forschungsnetze, wobei in der BRD das Deutsche Forschungsnetz DFN mit seiner Hochgeschwindigkeitsinfrastruktur X-WiN als gemeinnütziger Verein organisiert ist, mit Hochschulen und Forschungseinrichtungen als Mitgliedern.

Qualitativ bedeutsam für den kapitalistischen Internetbetrieb in der BRD ist der Staat besonders in seiner Doppelrolle als Großaktionär und Regulierer des Erbmonopolisten Telekoma und damit dem Setzen von Rahmenbedingungen für den Telekommunikationsmarkt. Neben Preis- und Verfahrensregelungen für die Nutzung der Kupferdrähte zu den Endverbrauchern oder die Durchleitung von Telefongesprächen, geht es mittlerweile auch um die Rahmenbedingungen der anstehenden technologischen Innovation, nämlich der kompletten Umstellung der Kommunikationsnetze auf paketvermittelte sog. Next Generation Networks [ Bundesnetzagentur ]. Diese Bemühung ist insbesondere zu verstehen vor dem Hintergrund der oben dargestellten kapitalismusbedingten Schwierigkeiten technischer Innovation bei Netzinfrastrukturen in verteiltem Besitz.

Auf der Ebene der Inhalte betätigt sich der Staat im Internet sowohl als Handlanger als auch in eigener Sache. Zunächst zu seiner Rolle als Handlanger. Kapitalistische Unternehmen bedienen sich gerne der Justiz, um unliebsame Kritik zu unterbinden. Für derlei Kritik ist das Internet, insbesondere das WWW, ein praktischer Nährboden. Auch Individuen oder kleine Gruppen können hier publizieren, wobei selbst kritische Informationen durch Verlinkungen und Suchmaschinen eine viel weitergehende Verbreitung erreichen können als eine entsprechende Papierpublikation. Wer aber kritisch ist, ist meist ökonomisch schwach und darob fehlt dann leider die Rechtsabteilung, die der Klassenjustiz im Falle eines Konflikts mit einem kritisierten Unternehmen ein Urteil gegen ein solches abringen könnte.

Neben einem beträchtlichen Abmahnunwesen auch im bzw. gegen das Internet ist ein weiteres Tätigkeitsfeld der BRD-Justiz der sogenannte Schutz der Persönlichkeitsrechte von Nazis. Genau wie auf der Straße sind eigenständige, insbesondere wirksame Aktivitäten der Bevölkerung gegen die Enkel des Gröfaz unerwünscht. Und außerhalb der üblicherweise verdächtigen Dissidentenkreise greift der Staat zur Durchsetzung der Interessen der Copyright-Industrie zum Rundumschlag gegen Internet-NutzerInnen legislativ, juristisch und exekutiv. Durch Digitalisierung und die Distributionsmöglichkeiten des Internet sind die Kulturverwertungskonzerne faktisch zumindest teilweise überflüssig geworden und viele Text-, Musik- und FilmliebhaberInnen betätigen sich mittels file sharing (z.B. Tauschbörsen, peer-to-peer Netze) selbst als DistributorInnen digitalisierter Kulturgüter, zuungunsten der Profite der Copyright-Industrie. Zu Hintergründen des Spannungsfeldes von Rechteverwertung und Digitalisierung siehe "Die rechtliche Ordnung des Wissens" ([ Grassmuck ] S. 31-176).

Ein Dreh- und Angelpunkt der o.g. staatlichen Angriffe sowie des staatlichen Handelns "in eigener Sache" ist die Verknüpfung von virtueller und realer Identität von NutzerInnen. Dazu sind den Internet- und Telefonie- Providern in den letzten Jahren Hilfstätigkeiten aufgebürdet worden, die zunächst die Erfassung von Kundendaten und ihre Verfügbarmachung für die Staatsorgane umfassen. Anonymisierungsdienste wie Tor waren in der BRD bereits Ziel fadenscheinig begründeter staatlicher Repression und sollen im Zuge der u.g. Vorratsdatenspeicherung in der BRD im Endeffekt verboten werden. Aber auch bei der Überwachung der Inhalte von Telekommunikation hat es gesetzliche "Fortschritte" gegeben, die die Anbieter von Telekommunikationsdiensten zur Bereithaltung von Überwachungstechnik verpflichtet - auf Kosten der Provider und damit letztlich der überwachten Kunden. Diese Überwachungstechnik müssen sie dann auf Anordnung der berechtigten Stellen (Strafverfolgung, Nachrichtendienste) einsetzen, um von den verdächtigten Nutzern die Kommunikation (Telefon, e-mail, gesamter Internettraffic eines verdächtigten Anschlusses) in Kopie dem jeweiligen Staatsorgan zu übermitteln.

Aktueller Höhepunkt der Überwachungswelle ist die auf EU-Ebene angeordnete Vorratsdatenspeicherung, mit der die gesamten Verbindungsdaten von Telefonie (egal ob leitungsvermittelt, mobil oder via Internet), SMS, FAX und e-mail, außerdem die Zuordnung von IP-Adressen an Kunden von Internet-Zugangsprovidern sowie Gerätekennung und Standort von Mobilfunkgeräten [ AK Vorrat ]. Diese sind von den jeweiligen Telekommunikations- bzw. Internetprovidern in der BRD vollständig für ein halbes Jahr zu speichern, in anderen EU-Ländern sind es bis zu zwei Jahren. Die gesamte telekommunizierende Bevölkerung wird also einem Generalverdacht auf Kriminalität unterworfen.

Die Verbindungsdaten sind natürlich auch ohne die kommunizierten Inhalte schon höchst interessant um soziale, d.h. potentiell kriminelle, Beziehungsnetze erkennen und analysieren zu können. Eine formale Handhabe zum Zugriff auf die Daten bei den Providern lässt sich gerade bei Dissidenten notfalls immer konstruieren, beliebt sind dafür die sog. Ausforschungsparagraphen 129/a/b des StGB. Jüngere Beispiele dafür waren 2007 im Vorfeld des G8-Gipfels in Heiligendamm groß angelegte Razzien des BKA gegen diverse soziale Bewegungen, die auch gegen den G8-Gipfel mobilisierten, sowie jahrelanges intensives Abhören und Observieren von AktivistInnen, teils auf Betreiben des Verfassungsschutzes ([ Betroffene ], [ Schmidt ], [ Einstellung ]). Dass der heutige selbsternannte Anti-Terror Rechts-Staat darüber hinaus auch immer weniger auf die Lehren aus der deutschen Geschichte gibt, sieht man z.B. an der sogenannten Antiterrordatei, einer Zusammenschaltung von Datenbeständen der Strafverfolgungsbehörden und der Nachrichtendienste von Bund und Ländern, welche dem Trennungsgebot von Polizei und Nachrichtendiensten offensichtlich widerspricht.